前回の記事では、ラフを用意して、AIでペン入れと彩色が可能か試してみました。

今回は、ペン入れした画像を用意して、AIで自動彩色が可能か試してみました!

ペン入れした画像を用意

アイドリッシュセブンの「小鳥遊紡」ちゃんです。

アニメを見てハマったので気まぐれで描いたものの、色を塗るのがめんどくさくてペン入れだけして放置していました。

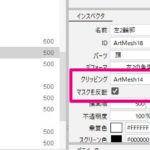

諸事情により、背景色と一体化していました。消しとけよ。

フリルペン(背景色あり)を使いたいがためのイラストだったので、不要な部分をレイヤーで上書きするために重ねたやつしか残ってなかったのだった。

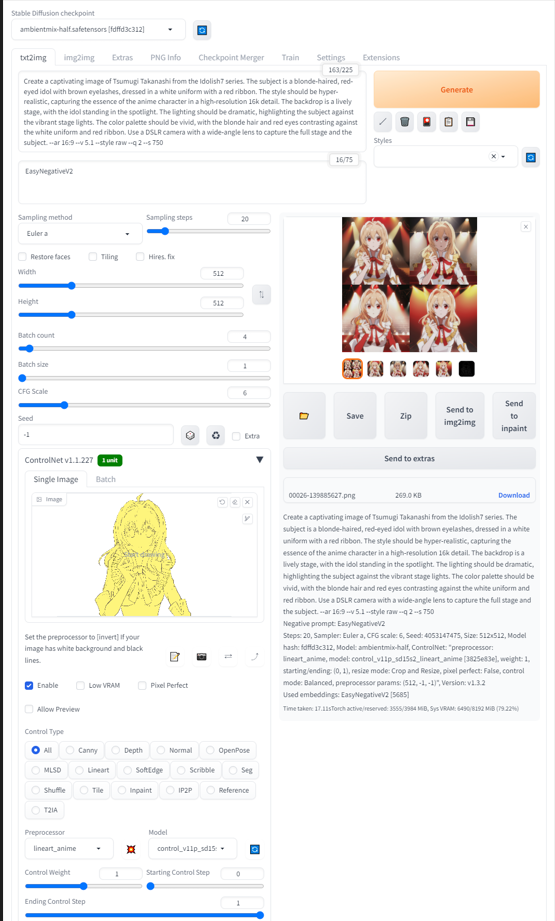

Stable Diffusionで基本的な設定

モデルの設定

前回に引き続き、使用するモデルは「ambientmix」です。

アニメ塗りで、自分の絵に近い結果が得られることを期待して選んでいます。

txt2imgの設定

下記1点を変更。他はデフォルト。

- CFG Scale : 6

ポジティブプロンプト

- プラチナブロンドの髪

- 赤い目

- 白い制服

- 赤いリボン

ネガティブプロンプト

- EasyNegativeV2

導入済みの「EasyNegativeV2」を入れています。

ControlNetの設定

下記2点を変更。他はデフォルト。

- Preprocessor : lineart_anime

- Model : lineart_anime

比較のため、前回の記事と同じ設定でいってみたよ。

生成結果

えっ、すごくないですか????

リボンとか細部が溶けてしまっていることを除けば、ニュアンスほぼそのまんまやで???

なお、袖の折返しのピンク色は反映されませんでした。

指示が悪いと思うのですが、どのようにお願いすればよかったんだろう。

ちなみに、既存キャラクターなのでプロンプトに名指ししてみたバージョンもあるけど、色設定は反映されませんでした。モデルとして利用されていそうな巨大ジャンルなら再現できるのかな。

まとめ

100%完全に塗ってくれるわけではないけど、軽く手入れすれば完成としても良さそう。

あとは用途によるかなぁ。自己満足のラクガキレベルならこれでいいのでは?

ペン入れしたら自動彩色できそう!

ただし、線や塗りが完全に再現されるわけではない。

Stable Diffusionは縦長のモニタが使いやすい

余談ですが。

新しいモニタを導入したので、配置の関係上、今まで使っていたモニタを縦にして使ってみたらまーーー使いやすい!

ControlNetを導入するとかなり縦長表示になって、スクロールすると「Generate」ボタンが隠れてしまうの地味にストレスだったので、これで解消できました。

モニタを縦にする必要性がわからなかったのですが、使う側の問題でした。

Twitter見るだけじゃなかったんだ。